安装Ollama

下载Ollama

登录 Ollama官网(https://ollama.com/) 下载 Ollama。

安装 Ollama

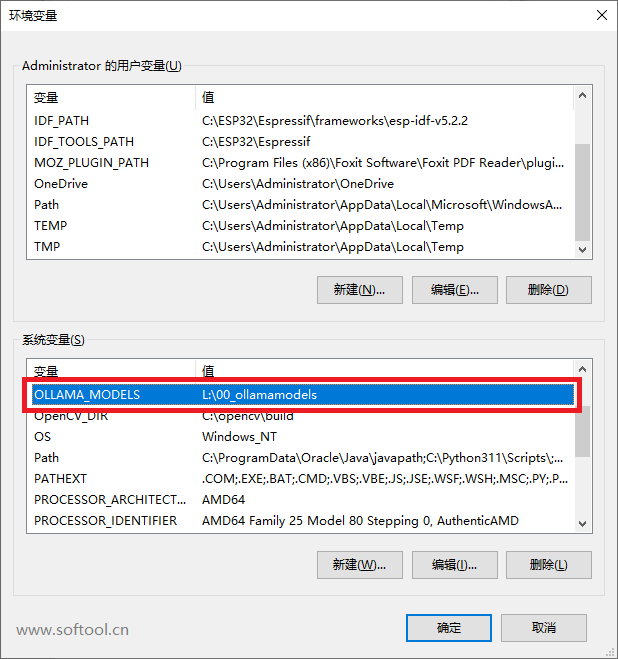

Ollama默认各位置:

默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama

默认安装的模型目录:C:\Users\username\ .ollama

默认的配置文件目录:C:\Users\username\AppData\Local\Ollama因为 Ollama 安装过程中不支持修改以后模型目录的下载位置,所以安装前需要修改系统环境变量:

安装完成之后打开终端,查看安装版本:

ollama -v下载模型

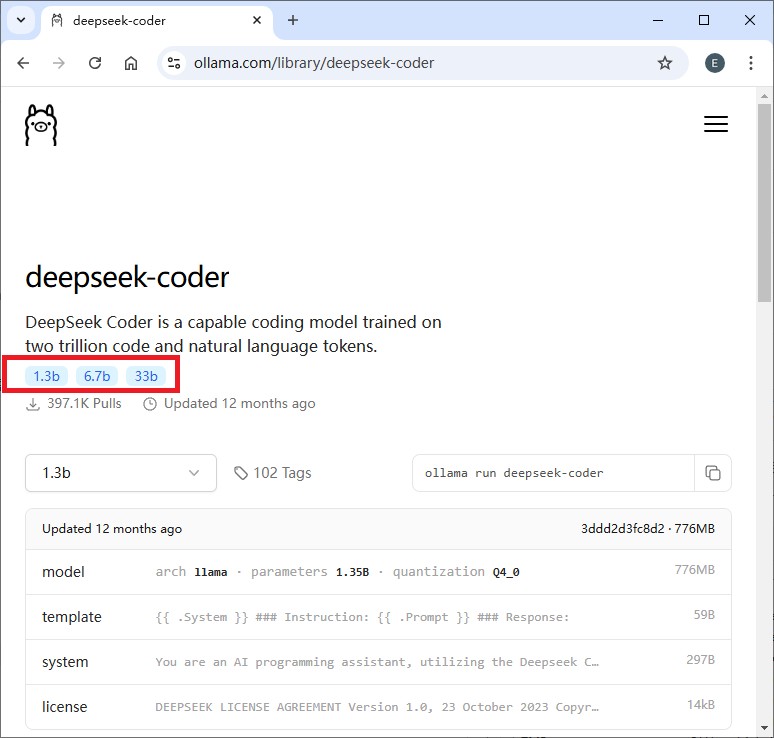

在 https://ollama.com/search 搜索需要下载的模型.

例如,想下载 deepseek-coder ,那么就搜索 deepseek-coder,那么会看到有三种参数:

假如想下载 33b 的 deepseek-codere,那么就可以运行:

ollama run deepseek-coder:33b安装 Docker

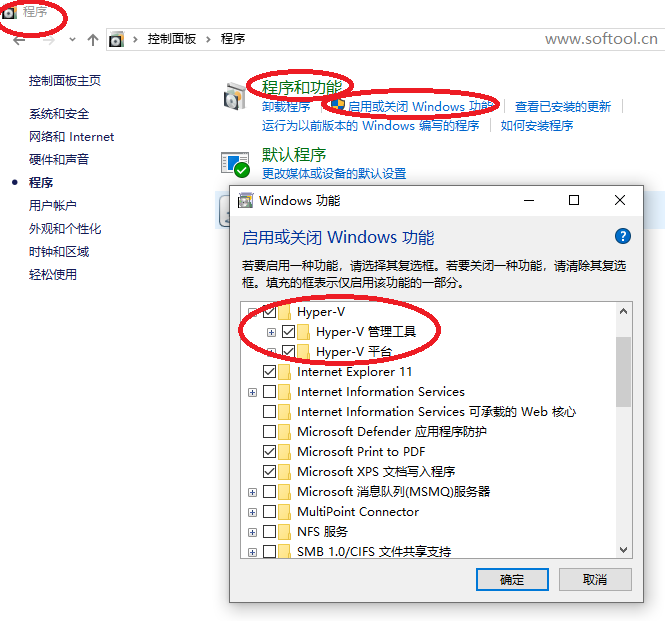

开启 Windows 系统虚拟化

勾选Hyper-V选项

官网下载:

https://docs.docker.com/desktop/setup/install/windows-install/

一路安装。

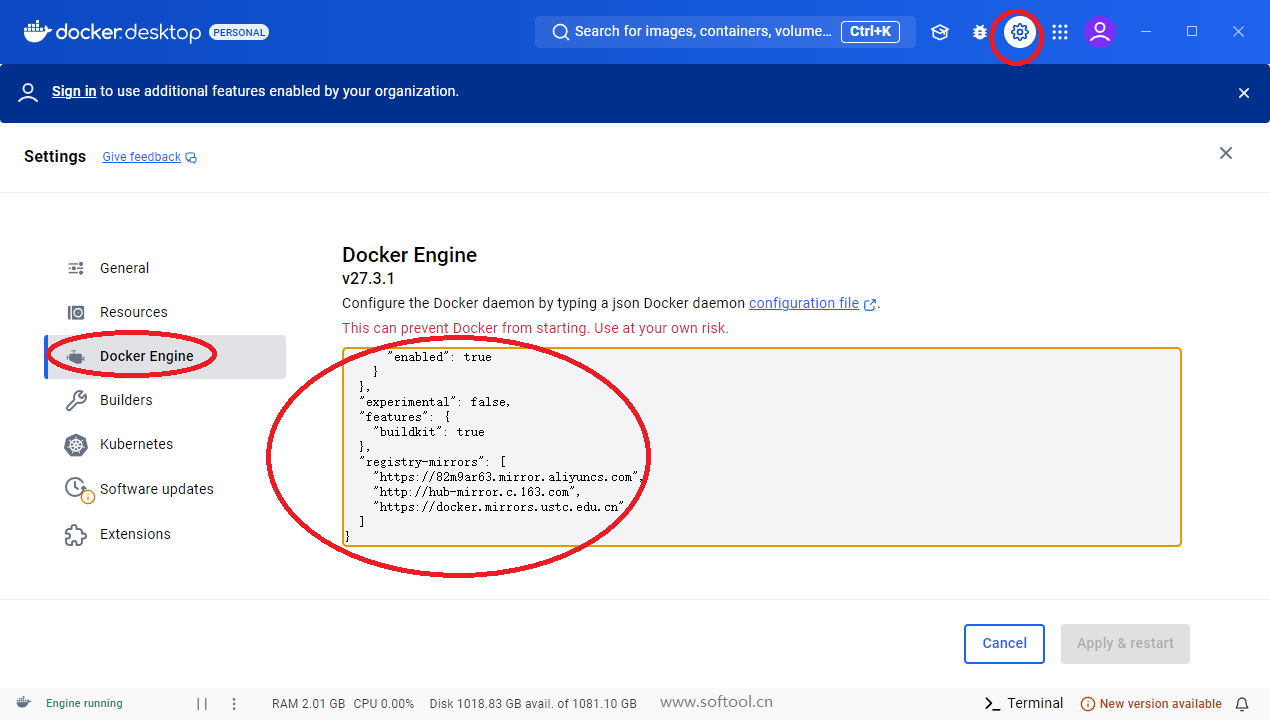

配置国内镜像源:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://82m9ar63.mirror.aliyuncs.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

]

}安装 OpenWebUI

下载地址: https://github.com/open-webui/open-webui

运行下面的命令之前,先启动 docker。

我使用的终端命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main浏览器地址栏访问: http://localhost:3000/

第一次注册即可(注册内容保存在本地)。

注册成功,左上角可选择自己的大模型。

效果演示:

来源:

https://blog.csdn.net/weixin_43012017/article/details/138253446